Переобучение, также известное как перегрузка информацией, - это явление, когда модель машинного обучения становится слишком сложной и слишком хорошо запоминает обучающий набор данных, но при этом плохо обобщает свои знания на новые данные. В результате, переобученная модель неспособна эффективно работать с реальными данными, в чем заключается одна из основных проблем в машинном обучении.

Причины переобучения могут быть разными. Одной из основных причин является недостаток разнообразия в обучающем наборе данных. Если модель обучается на малом количестве данных или на очень похожих данных, то она может не получить достаточно информации для правильного обобщения. Кроме того, переобучение может происходить из-за слишком сложной модели, которая может слишком точно "запомнить" все входные данные, вместо того чтобы найти общие закономерности.

Переобучение - определение, смысл, сущность

Основная причина переобучения заключается в том, что модель адаптируется к шуму в данных или к специфичным особенностям тренировочного набора данных, которые не являются общими для всей целевой области. По сути, модель "запоминает" тренировочные данные, но не обобщает их на новые примеры.

Переобучение может иметь серьезные последствия. Если модель переобучена, она может давать неправильные прогнозы или не эффективно использовать свои возможности при работе с новыми данными. Это может привести к неподходящим решениям, потере времени и ресурсов, а также к снижению надежности работы модели.

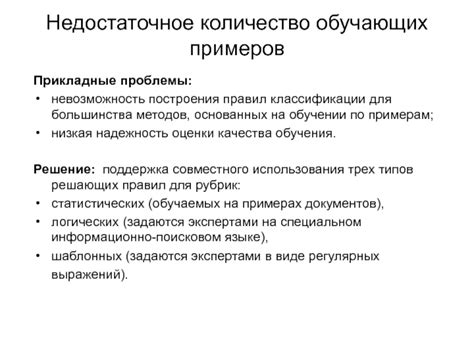

Чтобы избежать переобучения, необходимо принять ряд мер предосторожности. К ним относятся использование достаточно большого объема тренировочных данных, разделение данных на тренировочный набор, валидационный набор и тестовый набор, использование регуляризации для контроля сложности модели, а также использование методов отбора признаков для устранения нерелевантных и избыточных данных. Эти меры позволяют более точно настроить модель и снизить риск переобучения.

| Мера предосторожности | Описание |

|---|---|

| Использование большого объема тренировочных данных | Увеличение размера тренировочного набора данных помогает модели обобщить знания и избежать "запоминания" отдельных примеров. |

| Разделение данных на тренировочный, валидационный и тестовый наборы | Это позволяет оценить производительность модели на отдельном наборе данных, который не использовался при обучении. |

| Использование регуляризации | Регуляризация ограничивает сложность модели, предотвращая переобучение. Она добавляет штрафы за сложность модели в функцию потерь. |

| Использование методов отбора признаков | Отбор наиболее релевантных и информативных признаков помогает снизить размерность данных и устранить нерелевантные и избыточные данные. |

Определение переобучения в машинном обучении

Когда модель становится переобученной, она "запоминает" обучающий набор данных и начинает настраиваться на шумы и выбросы в нем. В результате модель может показывать высокую точность на обучающих данных, но низкую точность на новых данных.

Процесс обучения модели состоит из двух основных этапов:

- Этап обучения (тренировка) - модель алгоритма обучается на обучающих данных и настраивает свои параметры, чтобы минимизировать ошибку;

- Этап тестирования - модель проверяется на новых данных, чтобы оценить ее обобщающую способность и точность.

Переобучение происходит, когда модель слишком сильно адаптируется к обучающим данным и не учитывает шире генерализующую способность данных.

Для избежания переобучения можно применять следующие стратегии:

- Использовать больше разнообразных данных для обучения;

- Применять регуляризацию для контроля сложности модели;

- Использовать методы выбора признаков для устранения шумов и избыточности данных;

- Использовать кросс-валидацию для оценки производительности модели на разных наборах данных.

Определение и понимание переобучения в машинном обучении важно для разработчиков алгоритмов, чтобы создавать модели, которые обладают хорошей обобщающей способностью и показывают высокую точность на новых данных.

Смысл и сущность переобучения в контексте обучающей выборки

Основной смысл и сущность переобучения заключается в том, что модель становится "слишком умной" в отношении данных, которые она использовала в процессе обучения. При этом, модель становится нерепрезентативной для новых, ранее невиданных данных.

Переобучение возникает из-за несбалансированности обучающей выборки, когда одни классы представлены значительно большим количеством примеров, чем другие. Это приводит к тому, что модель становится очень хорошо обучена на классы с большим количеством данных, но менее успешна в распознавании классов с меньшим количеством данных.

Еще одной причиной переобучения является использование модели, имеющей слишком много параметров, по отношению к размеру обучающей выборки. В этом случае, модель может "запоминать" данные обучающей выборки, вместо того, чтобы выявлять общие закономерности в данных.

Последствия переобучения весьма негативны. Модель не сможет давать точные предсказания на новых данных и станет неустойчивой в отношении изменений в обучающей выборке. Это может привести к значительному ухудшению качества работы модели в реальных условиях.

Чтобы предотвратить переобучение, необходимо следить за балансом классов в обучающей выборке и подбирать оптимальное количество параметров модели в соответствии с объемом данных.

Причины переобучения

- Недостаток данных: Одной из основных причин переобучения является недостаточное количество данных для обучения модели. Если используемые данные слишком малы или не представляют все возможные варианты, модель может выучить эти данные слишком хорошо, но не сможет обобщить свои знания на новые данные.

- Шумные данные: Если в обучающих данных присутствует шум или ошибки, модель может адаптироваться к этим неправильным значениям и стать переобученной.

- Сложность модели: Использование слишком сложной модели, например, модели с большим количеством параметров, может привести к переобучению. Такие модели могут "запомнить" обучающие данные, но не смогут предсказывать новые данные эффективно.

- Некорректное разделение данных: Если данные неправильно разделены на обучающую и тестовую выборки, может возникнуть переобучение. Например, если обучающая выборка содержит слишком мало данных или не представляет всю разнообразность данных.

- Подгонка параметров: Когда параметры модели настраиваются слишком точно на обучающих данных, это может привести к переобучению. Модель становится слишком специфичной для обучающих данных и не сможет работать хорошо с новыми данными.

Чувствительность модели к шуму в данных

Переобучение модели может происходить из-за чувствительности модели к шуму в данных. Шум представляет собой непредсказуемую или случайную вариацию в данных. Когда модель обучается на данных, содержащих шум, она может начать усваивать этот шум вместо общих закономерностей или сигналов. Это приводит к неправильным или нерепрезентативным предсказаниям модели.

Чувствительность модели к шуму может проявляться на разных уровнях обучения:

- На уровне данных: модель может слишком подстраиваться под выбросы или аномалии в данных, вместо выявления общей структуры или закономерностей.

- На уровне признаков: модель может неправильно оценивать важность разных признаков, и сосредоточиваться на шумовых признаках вместо существенных.

- На уровне параметров: модель может настраивать свои параметры таким образом, чтобы точно предсказывать шумовые сигналы, но упускать общие закономерности.

Чувствительность модели к шуму может быть вызвана разными причинами:

- Неадекватность предобработки данных: если данные не были корректно обработаны в ходе предварительной обработки, в них может содержаться шум, который модель будет пытаться моделировать.

- Недостаточное количество данных: если доступно только ограниченное число образцов данных, модель может не иметь достаточной репрезентативности, и предсказания будут сильно зависеть от шума в этих данных.

- Избыточное количество признаков: если количество признаков в данных слишком большое по сравнению с размером выборки, модель может начать настраиваться на шумовые признаки, а не на общие закономерности.

- Низкое отношение сигнал/шум в данных: если шум в данных преобладает над сигналом, модель будет более внимательно настраиваться на шум, игнорируя при этом сигнал.

Чтобы уменьшить чувствительность модели к шуму в данных, необходимо:

- Выполнить предобработку данных: удалить выбросы, исправить ошибки, устранить аномалии, стандартизировать и нормализовать данные. Это поможет снизить влияние шума на модель.

- Собрать больше данных: чем больше образцов данных доступно для обучения модели, тем менее она будет чувствительна к шуму. Это позволит модели выявлять общие закономерности, игнорируя шум.

- Отобрать значимые признаки: провести анализ признаков и исключить шумовые или нерелевантные признаки. Таким образом, модель будет сосредоточиваться на существенных и информативных признаках.

- Использовать регуляризацию: регуляризация может помочь сдерживать модель от настройки на шумовые сигналы и сосредоточиться на общих закономерностях. Это позволит уменьшить переобучение и улучшить обобщающую способность модели.

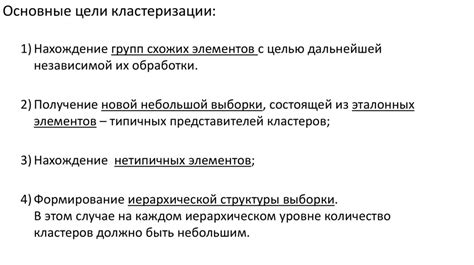

Недостаточное количество обучающих примеров

Ограниченное количество обучающих примеров может быть вызвано различными факторами. В некоторых случаях это может быть связано с трудностями в сборе и аннотации большого объема данных. Также могут возникнуть ограничения в доступности качественных данных, особенно в случае, если требуются особенные условия для их сбора.

Недостаточное количество обучающих примеров может привести к неверной обобщающей способности модели. Она может начать выдавать неправильные результаты, когда сталкивается с новыми, ранее не встречавшимися данными. Это может привести к отказу модели в реальных приложениях или к снижению ее точности и надежности.

Для решения проблемы недостаточного количества обучающих примеров можно предпринять несколько мер. Одним из вариантов является сбор дополнительных данных для обучения модели. Это может включать в себя проведение дополнительных экспериментов или расширение исходных данных с помощью различных методов, например, искусственного синтезирования.

Также можно использовать методы предобучения и переноса обучения. Предобучение модели на более крупном наборе данных, а затем дообучение на более ограниченном наборе данных, может помочь избежать переобучения и улучшить обобщающую способность модели. При использовании методов переноса обучения модель обучается на одной задаче, а затем применяется к другой, связанной задаче, используя уже полученные знания и опыт.

| Проблема | Причина | Решение |

|---|---|---|

| Недостаточное количество обучающих примеров | Трудности в сборе и аннотации данных | Сбор дополнительных данных или искусственное синтезирование |

| Ограничения доступности качественных данных | Использование методов предобучения и переноса обучения |

Сложность модели и ее степень адаптации

Проблема заключается в том, что сложные модели могут выучить даже шумовые свойства тренировочных данных, что приводит к плохой обобщающей способности и высокой ошибке на тестовых данных. Это явление называется переобучением.

Чтобы бороться с переобучением, необходимо использовать различные методы регуляризации, такие как усечение весов или добавление штрафов за сложность модели в функцию потерь. Это позволяет снизить степень переобучения и улучшить обобщение модели на новых данных.

Кроме того, можно использовать методы снижения сложности модели, например, уменьшение числа слоев нейронной сети или уменьшение размерности признакового пространства. Это может улучшить адаптацию модели и увеличить ее способность к обобщению.

Важно подобрать оптимальную сложность модели, которая будет достаточной для адаптации к данным, но при этом не будет слишком сложной, чтобы избежать переобучения. Для этого можно использовать методы кросс-валидации, которые позволяют оценить обобщающую способность модели на валидационных данных.

| Модель | Сложность | Степень адаптации |

|---|---|---|

| Линейная регрессия | Низкая | Высокая |

| Нейронная сеть | Высокая | Низкая |

| Решающее дерево | Средняя | Средняя |

Последствия переобучения

1. Снижение обобщающей способности модели. Переобученная модель может показывать очень хорошую производительность на данных, на которых она обучалась, но ее способность к обобщению на новые данные снижается. Это значит, что модель может давать неверные прогнозы или плохо справляться с новыми ситуациями.

2. Расход ресурсов. Переобученная модель может быть очень сложной и содержать большое количество параметров. Это может привести к тому, что модель будет использовать больше памяти и времени для обработки данных, что может быть неприемлемо в практических приложениях.

3. Границы применимости. Переобученная модель может быть специфична для определенных данных или задач и не сможет применяться в других контекстах. Это может ограничивать возможности использования модели для решения различных задач и снижать ее ценность в общем смысле.

4. Неустойчивость к шуму и выбросам. Переобученная модель может быть очень чувствительной к шуму и выбросам в данных. Это может привести к тому, что модель будет давать неправильные прогнозы или сильно менять свое поведение при небольших изменениях в данных.

| Негативные последствия | Переобучение |

|---|---|

| Снижение обобщающей способности модели | + |

| Расход ресурсов | + |

| Границы применимости | + |

| Неустойчивость к шуму и выбросам | + |

| Сложности в интерпретации | + |

Потеря обобщающей способности модели

Это может происходить из-за нескольких факторов. Во-первых, использование слишком сложной модели может привести к переобучению. Если модель имеет слишком много параметров, она может запомнить обучающие данные, но терять способность обобщать эти данные на новые примеры.

Во-вторых, недостаточность данных может привести к потере обобщающей способности модели. Если в обучающей выборке недостаточно разнообразных примеров, модель может выучить только их и не сможет предсказывать данные, которые отличаются от тех, что были представлены в обучающей выборке.

Также, использование неподходящих признаков или слишком сложных вычислительных методов может привести к потере обобщающей способности модели. Если признаки не достаточно информативны или неудачно выбраны, модель может терять способность к правильному обобщению данных.

Итак, чтобы избежать потери обобщающей способности модели, необходимо внимательно выбирать сложность модели, иметь достаточное количество разнообразных данных, подбирать информативные признаки и использовать подходящие методы обучения.

Появление ложных сигналов и неверных предсказаний

Переобучение происходит, когда модель становится неспособной обобщать данные и начинает "запоминать" обучающую выборку, вместо того чтобы извлекать из нее общие закономерности. Это приводит к тому, что модель начинает реагировать на шумовые данные или на зависимости, которые являются случайными или несущественными.

Чтобы избежать появления ложных сигналов и неверных предсказаний, необходимо внимательно подходить к процессу обучения модели и контролировать ее сложность. Для этого можно использовать методы регуляризации, такие как добавление штрафа за сложность модели или использование подходов к уменьшению размерности данных.

Также важно иметь правильно сформулированную задачу обучения и хорошо размеченные данные. Недостаток данных или нерепрезентативность обучающей выборки может привести к появлению ложных сигналов и неверных предсказаний.

| Причины появления ложных сигналов и неверных предсказаний: |

|---|

| Неправильная или неудовлетворительная обработка данных |

| Неоднородность данных |

| Плохо сформулированная задача обучения |

| Малое количество обучающих данных |

Для успешного избежания ложных сигналов и неверных предсказаний необходимо проводить регулярный анализ модели, контролировать ее сложность и качество предсказаний на тестовой выборке. Также важно следить за качеством обучающей выборки и правильно формулировать задачу обучения.

Снижение качества прогнозных моделей на новых данных

Снижение качества прогнозных моделей на новых данных может быть вызвано несколькими факторами. Один из них – недостаточная вариативность обучающих данных. Если модель обучается на данных, которые недостаточно разнообразны и не покрывают все возможные варианты, то она может не справиться с предсказанием новых данных, которые могут иметь совершенно другие характеристики.

Еще одной причиной снижения качества моделей на новых данных может быть нерепрезентативность обучающей выборки. Если обучающая выборка не является репрезентативной, то модель будет обучаться на данных, которые не отражают реальные закономерности и связи между переменными. В результате модель будет плохо работать на новых данных, которые имеют другие распределения и свойства.

Другой фактор, приводящий к снижению качества моделей на новых данных, – это переобучение модели на шумовых данных. Если обучающие данные содержат шум и аномалии, то модель может выучить их и использовать для предсказания новых данных. Это приведет к неправильным предсказаниям и снижению качества модели.

Все эти факторы могут привести к снижению качества прогнозных моделей на новых данных и сделать их непригодными для использования в реальных условиях. Поэтому важно проявлять осторожность при обучении моделей и учитывать все возможные источники переобучения.