В современном мире мы все стали зависимы от компьютеров и интернета. Мы пользуемся ими каждый день, но мало кто задумывается о том, как они работают и как достигают такой невероятной скорости и эффективности. Ключевыми элементами в работе компьютеров являются две цифры - 0 и 1. Но что же они означают в информатике?

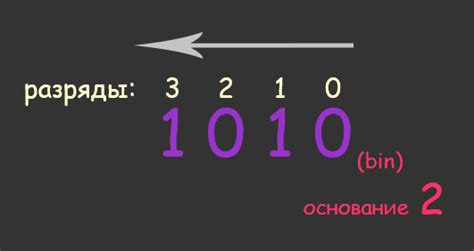

В информатике 0 и 1 используются для представления двоичной системы счисления. Эта система основана на двух символах - 0 и 1, которые называются битами (от англ. bit - binary digit). Они представляют малейшую единицу информации, которую можно записать и обрабатывать компьютерами. Ноль (0) обозначает отсутствие сигнала или логическое «ложь», а единица (1) обозначает наличие сигнала или логическую «истину».

Двоичная система счисления является основой работы всех цифровых устройств - компьютеров, телефонов, планшетов и многих других. Ее использование обеспечивает гибкость, эффективность и точность вычислений. При помощи 0 и 1 можно представить и обрабатывать различные данные, такие как числа, текст, звук, фотографии и видео.

0 и 1 в информатике: значение и применение

Значение 0 и 1:

Число 0 представляет отсутствие сигнала или логический ноль. Оно обозначает отрицательное состояние или отключенное состояние, в отличие от числа 1, которое представляет наличие сигнала или логическую единицу. В двоичной системе, 0 и 1 могут быть интерпретированы как ложь и истина соответственно.

Применение 0 и 1:

Одним из основных применений 0 и 1 является их использование для хранения информации и передачи данных в компьютере. Все данные в компьютере, включая текст, изображения, аудио и видеофайлы, могут быть представлены в виде наборов 0 и 1.

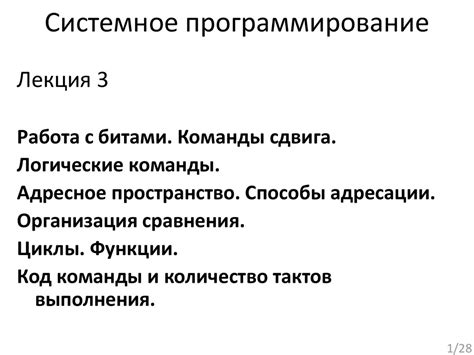

0 и 1 также используются для выполнения логических операций, таких как логическое И (AND), логическое ИЛИ (OR), логическое НЕ (NOT) и др. Эти операции позволяют программистам создавать сложные логические условия,

Использование 0 и 1 в информатике расширяется и на другие области, такие как криптография, сетевые протоколы и электроника. Например, в криптографии 0 и 1 используются для шифрования и расшифрования сообщений.

Откуда пошло 0 и 1 в информатике?

Идею использования двоичной системы числения можно проследить до древнейших времен. Еще в древности люди различали два противоположных состояния - что-то может быть или не быть, включено или выключено, светло или темно. Бинарный принцип был применен еще в древности в различных областях жизни, начиная от использования огня и заканчивая созданием двоичных систем права.

Однако, именно в XX веке двоичная система числения получила широкое применение в информатике. Это связано с электричеством и использованием транзисторов. В электрической системе есть два состояния: напряжение есть или его нет. Иными словами, электрический сигнал может принимать два значения, которые эквивалентны 0 и 1. Такой принцип стал использоваться в электронных компьютерах и дал начало современной информатике.

Таким образом, применение двоичной системы числения в информатике отражает фундаментальные свойства электричества и его возможность представления информации в виде двух состояний. Благодаря этому простому, но мощному принципу, мы имеем возможность обрабатывать и хранить огромные объемы данных, что стало основой современного информационного общества.

Бинарная система счисления и 0 и 1

В бинарной системе счисления числа записываются с использованием только двух цифр. Концепция этой системы основана на двоичной арифметике, которая отличается от десятичной арифметики, которую мы используем в повседневной жизни.

Вся информация в компьютерной системе представляется в виде последовательности битов - единиц и нулей. Например, чтобы представить число 5 в двоичной системе счисления, требуется использовать следующую последовательность: 101.

Бинарные числа также используются для представления символов и текста. Каждый символ имеет свое уникальное представление в виде последовательности битов. Например, буква "А" может быть представлена в ASCII кодировке как 01000001. При обработке текстовой информации компьютеры используют кодировки, такие как ASCII, Unicode и UTF-8.

Бинарная система счисления является основой для работы компьютеров и других электронных устройств. Она позволяет представлять и обрабатывать информацию в виде двух состояний - 0 и 1, что делает ее эффективной и надежной для хранения и передачи данных.

Кодирование информации: зачем нужны 0 и 1?

Двоичная система счисления, основанная на использовании 0 и 1, является фундаментальным способом представления информации в компьютерах. Каждое число, символ или другие данные могут быть представлены в двоичной форме, используя только два символа 0 и 1.

Зачем же нужны 0 и 1? Ответ кроется в том, что компьютеры работают на основе электрических сигналов, которые имеют два состояния: присутствие и отсутствие сигнала, которые соответствуют значениям 1 и 0. Это позволяет компьютеру легко различать и обрабатывать информацию, используя электрическую цепь.

Для представления букв, цифр, знаков препинания и других символов также используются двоичные коды, которые позволяют компьютерам хранить и обрабатывать различные типы данных. Например, алфавитные символы могут быть представлены с помощью ASCII-кода, где каждому символу сопоставлено уникальное число в двоичной форме.

Использование 0 и 1 в информатике обеспечивает единообразные и стандартизированные способы представления и обработки информации, что делает возможным обмен и совместное использование данных между разными компьютерами и программами.

В итоге, использование двоичной системы счисления и символов 0 и 1 в информатике является неотъемлемой частью создания, хранения и передачи данных. От понимания этого основополагающего принципа зависит функционирование современных компьютерных систем.

Соответствие между 0 и 1 и логическими значениями

В информатике и логике существует прямая связь между числами 0 и 1 и логическими значениями "ложь" и "истина". Это базовые единицы, на которых построены все цифровые устройства и компьютерные системы.

Цифра 0 обозначает логическое значение "ложь", то есть отсутствие какого-либо действия или события. Например, в двоичной системе численного представления данных, 0 означает, что в данном разряде отсутствует электрический сигнал. В логических операциях, 0 может также обозначать несоответствие условию, отрицание или неверное утверждение.

Цифра 1, напротив, представляет логическое значение "истина". Она показывает наличие какого-либо действия или события. В двоичной системе, 1 обозначает наличие электрического сигнала в данном разряде. В логических операциях, 1 может быть использована для обозначения соответствия условию, утверждения или положительного результата.

Соответствие 0 и 1 логическим значениям является основой для построения алгоритмов и вычислений в компьютерных системах. С их помощью, можно создавать сложные логические условия, выполнять операции с данными и принимать логические решения.

Как 0 и 1 применяются в цифровой электронике

В современном мире цифровая электроника играет огромную роль во множестве областей, от компьютерных систем до мобильных устройств и автомобилей. Принцип работы цифровой электроники основан на использовании двух состояний: 0 и 1, которые представляют собой базовые элементы информации. Подробнее о том, как 0 и 1 применяются в цифровой электронике, вы узнаете из этой статьи.

В цифровой электронике, 0 и 1 называются двоичными цифрами, или битами (от англ. binary digit). Каждый бит может принимать одно из двух возможных значений: 0 или 1. Эти два состояния часто интерпретируются как логические значения, например, "выключено" и "включено", "ложь" и "истина".

Однако, 0 и 1 в цифровой электронике используются не только для представления логических значений, они также служат для представления чисел и других форм информации. Например, числа могут быть записаны в двоичной системе счисления, где каждый разряд может быть 0 или 1. Это позволяет компьютерным системам эффективно хранить, передавать и обрабатывать числовую информацию.

Кроме того, в цифровой электронике 0 и 1 используются для представления состояний переключателей и реле, а также для управления работой различных компонентов и устройств. Например, в компьютерной системе, цифровой сигнал может быть использован для передачи данных по проводам и интерфейсам, а также для управления работой процессора, памяти и других компонентов.

| Применение цифр 0 и 1 в цифровой электронике: |

|---|

| 1. Представление логических значений: 0 - ложь, 1 - истина. |

| 2. Представление числовой информации в двоичной системе счисления. |

| 3. Управление работой компонентов и устройств. |

| 4. Передача данных по проводам и интерфейсам. |

Работа компьютерного процессора с битами 0 и 1

Биты 0 и 1 играют важную роль в информатике, особенно в работе компьютерного процессора. Компьютерные процессоры работают с электрическими сигналами, которые могут иметь только два состояния: 0 или 1.

Все данные в компьютере представлены в двоичном виде, используя комбинации битов 0 и 1. Компьютерный процессор производит операции с этими двоичными данными, включая сложение, вычитание, умножение и деление.

Каждый бит в компьютере представляет одно из двух состояний: 0 или 1. В зависимости от этого состояния, компьютер может выполнить различные операции. Например, если бит имеет значение 0, это может означать выключенное состояние или логическое ложное значение, а если бит равен 1, это может означать включенное состояние или логическую истину.

Комбинация битов используется для представления более сложных типов данных, таких как числа, символы и текст. Например, 8 битов (байт) могут представить число от 0 до 255, где каждый бит отвечает за определенную степень двойки в числе.

Использование битов 0 и 1 в информатике позволяет компьютерам выполнить сложные операции, а также сохранять и передавать данные. Биты 0 и 1 составляют основу цифровой информации и определяют возможности современных компьютерных систем.

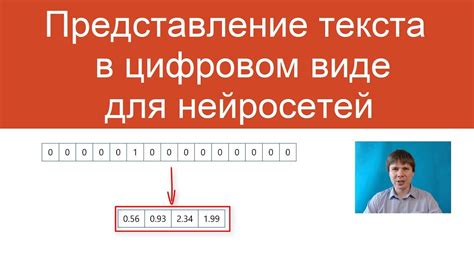

Представление текста с помощью 0 и 1

Каждый символ в тексте может быть преобразован в соответствующую двоичную последовательность, называемую кодом символа. Существует несколько различных кодировок для представления текста, таких как ASCII, UTF-8 и Unicode, каждая из которых имеет свои особенности и распространенность.

Самая распространенная кодировка ASCII (American Standard Code for Information Interchange) использует 7 бит для представления каждого символа. В этой кодировке у каждого символа есть уникальный номер, который представляется в двоичном виде. Например, буква "A" имеет код 65, который в двоичном виде будет выглядеть как 01000001.

В более современных кодировках, таких как UTF-8 и Unicode, используется переменное количество бит для представления символов текста. Это позволяет представить гораздо больше символов, включая символы различных языков и специальные знаки. Каждый символ в UTF-8 и Unicode имеет свой уникальный код, который может быть представлен в двоичной форме.

Представление текста с помощью 0 и 1 является основным принципом работы компьютерных систем. Благодаря этому представлению, сообщения могут быть переданы и обработаны компьютерами и другими электронными устройствами с высокой скоростью и надежностью.

Значение 0 и 1 в сетях передачи данных

В сетях передачи данных, биты (0 или 1) используются для передачи информации между устройствами. Например, в Ethernet, сетевом протоколе, информация передается в виде последовательности битов, где 0 и 1 представляют состояние сигнала на проводнике. Комбинация битов может представлять данные, команды, адреса или любую другую информацию, необходимую для обмена между устройствами в сети.

При передаче данных по сети, информация преобразуется в последовательность битов, а затем передается по среде передачи, такой как провода или беспроводные каналы. Когда информация достигает адресата, биты декодируются обратно в исходную форму.

Использование двоичной системы счисления, основанной на символах 0 и 1, обеспечивает высокую надежность передачи данных. Она позволяет точно представить каждый бит информации и легко обнаруживать ошибки передачи. Также, двоичная система позволяет эффективно использовать аппаратные ресурсы для обработки и хранения данных.

Следует отметить, что в сетях передачи данных используются не только 0 и 1. Некоторые сетевые протоколы могут использовать дополнительные символы или комбинации битов для определенных целей, таких как контрольная сумма, кодирование ошибок и др. Однако, основная концепция передачи информации по сетям остается связанной с использованием двоичной системы счисления.

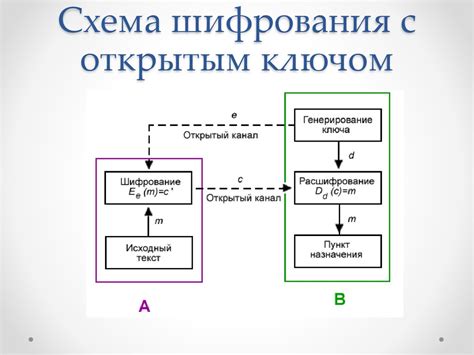

Безопасность и 0 и 1: шифрование данных

Шифрование данных - это процесс преобразования исходной информации в непонятный вид, который может быть восстановлен только с помощью специального ключа или пароля. Ключевой принцип шифрования заключается в использовании математических алгоритмов для изменения исходных данных в такую форму, которую трудно или невозможно взломать.

И здесь в игру вступают 0 и 1 - основные единицы информации в компьютерной науке. Шифрование данных основано на преобразовании обычного текста или файлов в последовательности бит - нулей и единиц. Каждый символ или байт исходных данных заменяется на соответствующую последовательность бит, которая становится непонятной и нечитаемой для посторонних лиц.

Применение шифрования данных позволяет обеспечить защиту информации от несанкционированного доступа или подмены данных. Без шифрования, данные могут быть легко прочитаны или изменены злоумышленниками. Однако с помощью шифрования, даже если кто-то получит доступ к зашифрованным данным, он не сможет прочитать их или восстановить оригинальную информацию без знания ключа.