Информация - одно из основных понятий в физике, изучающей связи между энергией и материей. В широком смысле, информация означает знания или данные, полученные из наблюдений, измерений или экспериментов. Однако в физике понятие информации имеет более глубокий смысл и тесно связано с основными законами природы.

Согласно физическому подходу, информация - это изменение состояния системы, которое мы можем регистрировать и интерпретировать. Таким образом, информация связана с измерениями и передачей сигналов, которые являются неотъемлемой частью любого физического процесса. Она может быть представлена в различных формах, таких как числа, символы, звук или свет, и передаваться с использованием разных сред передачи, таких как провода, волны или частицы.

Исток и сущность понятия "информация"

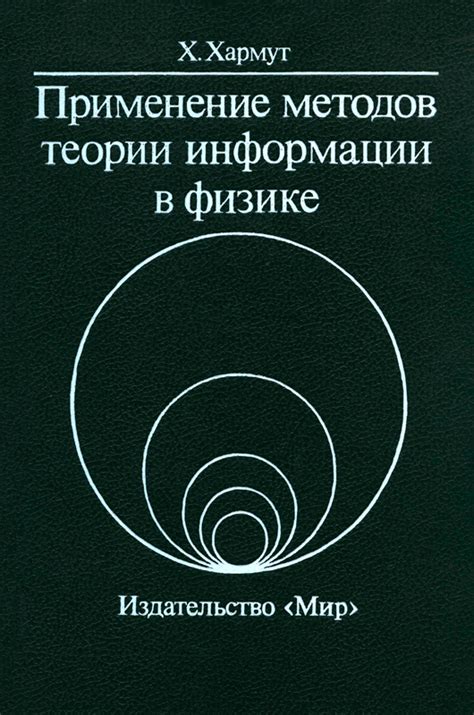

Понятие "информация" имеет глубокие исторические корни и широкий спектр интерпретаций. Оно возникло в физике в начале XX века и было развито в рамках информационной теории Клода Шеннона. Сущность понятия "информация" связана с передачей и получением знаний, фактов и идей.

Физика определяет информацию как отражение реальности и измеримую единицу данных. Она может быть представлена в разных формах, таких как звук, свет, текст и числа. Ключевая особенность информации - ее способность быть переданной и воспринятой.

С точки зрения физики, информация состоит из элементарных частиц, известных как биты. Каждый бит может принимать два значения - "0" или "1", что соответствует основному двоичному кодированию. Комбинация битов образует байты и более сложные структуры, позволяющие представлять и обрабатывать большие объемы информации.

Важным аспектом понятия "информация" является его связь со случайностью и неопределенностью. Измерение информации связано с вероятностными распределениями и статистикой. Чем меньше вероятность появления определенного сообщения, тем больше информации оно несет.

В целом, информация является одним из основных понятий физики, связанным с передачей, обработкой и пониманием данных. Она играет важную роль во многих областях, включая телекоммуникации, компьютерные науки и квантовую физику.

Определение информации в физике

В физике информацию можно определить как величину, которая содержит данные о состоянии или изменении состояния системы. Информация может быть количественной или качественной, и она играет важную роль в решении различных задач и понимании физических процессов.

Количество информации может быть измерено с использованием понятия энтропии. Энтропия определяет степень неопределенности системы и может быть связана с вероятностью возникновения различных состояний. Чем более неопределенная система, тем больше информации она может содержать.

Примером количественной информации может служить измерение плотности или температуры вещества. Качественная информация может быть связана, например, с цветом или формой объекта.

Физики также используют термин "сигнал" для описания информации. Сигналом может быть любая величина или комбинация величин, которая передает информацию о состоянии системы или процессе. Сигналы могут быть анализированы, передаваться или преобразовываться для получения дополнительной информации или совершения нужных действий.

Таким образом, информация в физике играет важную роль в понимании и описании физических явлений, а также в разработке новых технологий и решении практических задач.

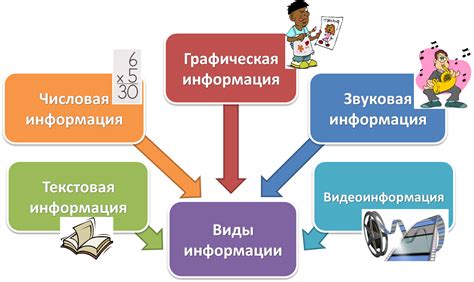

Виды информации по физическим характеристикам

Физика как наука изучает различные явления в природе, включая передачу информации. Информация может быть различной по своим физическим характеристикам, в зависимости от способа передачи и преобразования.

Вот некоторые виды информации, которые могут быть определены на основе физических характеристик:

- Аналоговая информация: это информация, которая представлена непрерывным сигналом. Примером аналоговой информации может служить звуковой сигнал, который может иметь различные амплитуду и частоту.

- Дискретная информация: в отличие от аналоговой информации, дискретная информация представляет собой дискретные состояния или символы. Например, цифровой сигнал может быть представлен дискретными единицами или нулями.

- Цифровая информация: это информация, которая представляет собой числа или символы, кодирующие различные значения. Цифровая информация может быть обработана и передана с большей точностью и надежностью, поскольку числа можно легко хранить и обрабатывать с помощью электронных устройств.

- Аналогово-цифровая информация: это информация, которая сочетает в себе черты аналоговой и цифровой информации. Например, аналоговый сигнал может быть сначала дискретизирован и затем преобразован в цифровой формат для обработки и передачи.

- Мультимедийная информация: это информация, включающая различные типы медиа-данных, такие как текст, изображения, звук и видео. Мультимедийная информация обычно требует большой пропускной способности и хранится в цифровой форме.

Понимание этих различных видов информации по физическим характеристикам помогает в разработке и применении различных технологий передачи и хранения информации, таких как радио, телевидение, интернет и многое другое.

Физические процессы передачи и обработки информации

В физике информация рассматривается как физическая величина, которая может быть передана с помощью физических процессов. Такие процессы включают передачу сигналов по проводам или беспроводным путем, обработку сигналов в электронных устройствах, а также хранение информации на физических носителях.

Передача информации может осуществляться по различным каналам связи, включая электромагнитные волны, световые сигналы или звуковые импульсы. В случае проводной коммуникации, информация передается через электрический ток. В беспроводных системах, таких как радио или сотовая связь, передача осуществляется с помощью радиоволн.

При обработке информации важную роль играют электронные устройства. Они выполняют функции кодирования, декодирования, усиления и фильтрации сигналов. Примерами таких устройств являются компьютеры, мобильные телефоны, радиоприемники и телевизоры.

Хранение информации может происходить на физических носителях, таких как магнитные диски, флеш-накопители или оптические диски. В таких системах информация записывается и считывается с помощью физических процессов, таких как магнитизация или освещение оптическим лучом.

Физические процессы передачи и обработки информации играют важную роль в современном мире. Они позволяют нам передавать и получать информацию с большой скоростью и эффективностью. Знание этих процессов помогает нам лучше понимать, как работает наша современная информационная инфраструктура и как можно ее улучшать.

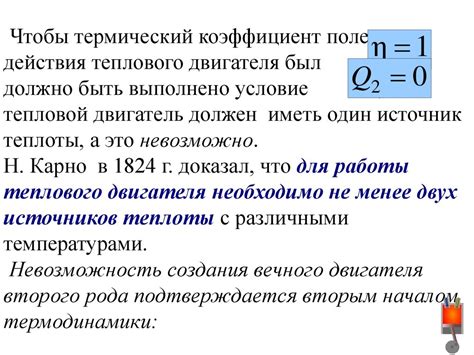

Понятие энтропии и связь с информацией

В терминах информации, энтропия может быть интерпретирована как количество информации, содержащейся в системе. Если система располагает меньшим количеством информации, то она более упорядочена и прогнозируема. В то же время, система с высокой энтропией содержит много информации и более непредсказуема.

Одним из примеров может быть текстовый документ. Если документ содержит много повторяющихся букв и слов, то его энтропия будет низкой, так как информация повторяется и предсказуема. Но, если документ содержит редкие или необычные слова, то энтропия будет высокой, так как информация не повторяется и более непредсказуема.

Важно отметить, что энтропия связана с вероятностной природой информации. Чем меньше вероятность наступления события, тем больше информации оно содержит. Например, в случае броска монеты, если есть равные шансы выпадения орла или решки, то информация о результате будет небольшой. Но, если есть монета с двумя орлами, то информация о выпадении решки будет большой, так как вероятность этого события очень мала.

В физике, энтропия имеет большое значение при изучении термодинамики и статистической физики. Концепция энтропии помогает понять, как системы стремятся к равновесному состоянию и как они изменяются со временем. Связь энтропии с информацией позволяет лучше понять, как информация распространяется и как системы обрабатывают информацию в современном мире высоких технологий.

Квантовая информационная теория и ее особенности

Основная особенность квантовой информационной теории заключается в том, что она учитывает эффекты, связанные с квантовой механикой, такие как суперпозиция и взаимодействие между квантовыми состояниями.

В квантовой информационной теории информация представляется в виде квантовых состояний. Они могут быть использованы для представления битов информации, но также могут иметь и более сложные формы. Например, в квантовых системах можно использовать кубиты – квантовые аналоги классических битов.

Одной из основных проблем в квантовой информационной теории является проблема сохранения информации при ее передаче и обработке. В квантовой механике имеется явление квантового измерения, которое приводит к коллапсу квантовой системы и потере информации.

Однако квантовая информационная теория также предлагает и ряд преимуществ. Во-первых, она открывает новые возможности для криптографии и передачи информации с повышенной безопасностью. В квантовой криптографии используются квантовые явления, такие как квантовое шифрование и квантовое распределение ключей.

Во-вторых, квантовая информационная теория является основой для развития квантовых вычислений. Квантовые компьютеры обладают потенциалом для решения сложных вычислительных задач, которые классические компьютеры не в состоянии решить за разумное время.

Таким образом, квантовая информационная теория открывает новые перспективы в области передачи и обработки информации, предлагая эффективные решения проблем классической информационной теории.

Роль информации в физических системах

Физика информации изучает преобразование, передачу и хранение информации в физических системах. Она рассматривает информацию как физическую величину, которая может быть измерена и передана через различные каналы связи.

В квантовой механике информация играет фундаментальную роль. Квантовые биты, или кубиты, являются основными единицами информации в квантовых системах. Квантовые вычисления позволяют обрабатывать и передавать информацию с использованием квантовых состояний и их суперпозиций.

Статистическая физика также связана с информацией. Она изучает свойства систем, состоящих из большого числа частиц, и их вероятностные распределения. Информация об этих распределениях и статистических свойствах может быть использована для предсказания и объяснения поведения физических систем.

Теория информации рассматривает информацию как абстрактную величину, отделенную от физического носителя. Она изучает различные аспекты информации, такие как ее количество, качество, степень сжатия и передачи. Теория информации также связана с обнаружением и исправлением ошибок, а также с криптографией.

Все эти области физики информации имеют важное значение для современных научных и технических достижений. Они помогают нам лучше понимать фундаментальные законы природы и разрабатывать новые технологии, связанные с обработкой и передачей информации. Информация является неотъемлемой частью нашей физической реальности и играет ключевую роль во многих аспектах нашей жизни.